در حال بارگذاری ...

بررسی انواع تست نفوذ به مدلهای هوش مصنوعی مثل Prompt Injection و Jailbreak

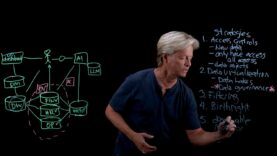

در این ویدیو قرار است در مورد روشهای نفوذ به مدلهای هوش مصنوعی صحبت شود. مدلهای AI غیرقابل نفوذ نیستند— حملاتی مانند Prompt Injection، Jailbreak و دادههای آلوده میتوانند امنیت آنها را تهدید کنند. در این ویدیو، روشهای تست نفوذ از جمله Sandboxing، Red teaming و اسکنهای خودکار برای حفاظت از مدلهای زبانی بزرگ (LLMs) […]

بستن